Il caso di Melissa Sims ha dimostrato quanto possano essere pericolosi i contenuti AI non controllati nel sistema legale. L'industria promette un rimedio sotto forma dei cosiddetti "rilevatori di AI", software destinati a utilizzare algoritmi complessi per riconoscere se un'immagine proviene da un essere umano o da una macchina. Tuttavia, l'affidabilità di questi cani da guardia digitali rimane dubbia di fronte all'inganno intenzionale. Un esperimento con sei dei servizi di rilevamento attualmente più comuni ha messo alla prova questo aspetto.

L'immagine di prova: Una sfida surreale

Per sfidare gli strumenti di rilevamento, abbiamo utilizzato il generatore di immagini basato su Google Gemini "Nano Banana Pro" Il prompt scelto era volutamente semplice ma leggermente stravagante: "Una donna in posa da combattimento che tiene in mano una banana contro il cielo. Sfondo tipico paesaggio urbano con persone disinteressate"

Tuttavia, il primo grande ostacolo per il software di rilevamento automatico deriva dal modello specifico utilizzato. Poiché Nano Banana Pro è relativamente nuovo sul mercato, presenta un punto cieco per molti rilevatori.

Questi servizi spesso si basano sull'apprendimento automatico e sono specificamente addestrati per identificare le firme uniche o "impronte digitali" di giganti affermati come Midjourney, DALL-E 3, Diffusione Stabile o Flux. Di conseguenza, un modello fresco come Nano Banana Pro gode di un netto vantaggio, in quanto i suoi modelli di generazione specifici non fanno ancora parte dei dati di addestramento dei rilevatori, il che gli consente di sfuggire più facilmente.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones

Round 1: fallimento nonostante le filigrane

Nella prima fase, i rilevatori hanno affrontato un compito facile. Il PNG originale è stato semplicemente convertito in un formato JPG e i suoi metadati sono stati eliminati. In particolare, l'immagine conteneva ancora una filigrana Gemini chiaramente visibile.

Si potrebbe pensare che un marchio AI visibile sia una facile preda per il software di rilevamento. Tuttavia, il risultato è stato sconfortante: anche in questo stato grezzo, due dei sei strumenti testati hanno fallito. Nonostante l'evidente filigrana, hanno classificato la probabilità che l'immagine fosse generata dall'AI come bassa.

Round 2: La gomma digitale

Nella seconda fase, ci siamo avvicinati a uno scenario realistico di contraffazione. La filigrana identificativa doveva scomparire. In pochi secondi, la gomma AI integrata nell'applicazione predefinita di Windows Photos ha completato il lavoro senza problemi.

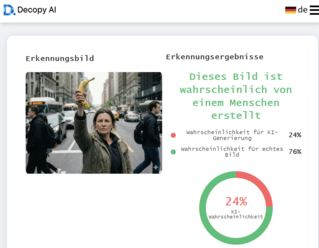

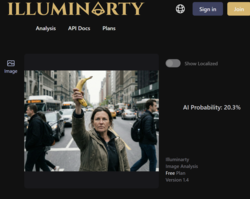

L'impatto di questa piccola modifica è stato immediato. Un altro strumento è stato ingannato, classificando ora la probabilità AI come bassa. È interessante notare, tuttavia, che Illuminarty ha effettivamente aumentato la sua valutazione di probabilità per un'immagine generata dall'AI dopo la modifica. Tuttavia, tre dei sei strumenti di rilevamento dell'AI hanno assegnato una probabilità inferiore al 30% che la donna con la banana fosse una creazione AI.

Round 3: La perfezione dell'imperfezione

Il passo finale è stato decisivo. Le immagini AI sono spesso "troppo lisce" e troppo perfette nella loro assenza di rumore. Per ingannare definitivamente i rilevatori, l'immagine aveva bisogno di una "realtà" artificiale, ovvero degli errori tipici della fotografia digitale. Utilizzando Cyberlink PhotoDirector, l'immagine è stata post-elaborata. È stata aggiunta una leggera correzione dell'obiettivo, l'aberrazione cromatica artificiale ha creato delle frange di colore ai bordi, è stato aumentato il contrasto e, soprattutto, è stato applicato un rumore d'immagine realistico sullo scenario. L'obiettivo era quello di far sembrare l'immagine come scattata da una fotocamera reale e imperfetta. Tutto questo è stato fatto in pochi minuti.

Immagine originale ed elaborata a confronto

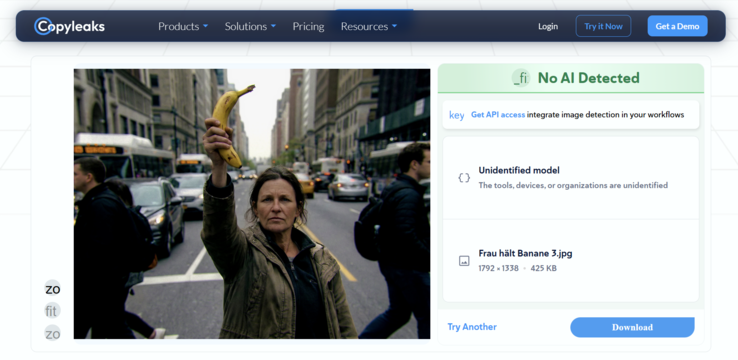

Il risultato di questo terzo round è stato una sconfitta totale della tecnologia di rilevamento. Dopo che l'immagine è passata attraverso questa post-elaborazione standard, tutti i sei servizi testati si sono arresi. Nessuno strumento ha indicato una probabilità AI superiore al 5 percento. Per il software, la donna che colpisce una banana era ormai senza dubbio una foto reale.

Verdetto: Un pericoloso senso di sicurezza

Il nostro esperimento evidenzia chiaramente che le attuali soluzioni tecniche per il rilevamento dell'IA sono ancora agli inizi. Se bastano pochi minuti e un software di editing fotografico standard per far scendere i tassi di rilevamento da "molto probabile" a "meno del 5%", questi strumenti non sono solo inutili per i tribunali, le redazioni giornalistiche o le forze dell'ordine: sono pericolosi. Creano un falso senso di sicurezza che semplicemente non esiste. Il principio "fidati, ma verifica" funziona solo se i verificatori non sono ciechi.