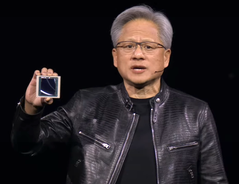

Il CEO di Nvidia Jensen Huang ha rivelato gli ultimi prodotti e servizi AI dell'azienda durante il keynote di GTC 2024 il 18 marzo 2024 a San Jose, CA. Destinate ai clienti aziendali, le nuove offerte di Nvidia promettono di accelerare notevolmente l'apprendimento e l'applicazione dell'AI in molti campi come la robotica, le previsioni meteorologiche, la scoperta di farmaci e l'automazione dei magazzini. La GPU Nvidia Blackwell, i NIM, il NEMO e la fonderia AI sono state tra le offerte più importanti presentate.

Il processo di addestramento dell'AI è molto più impegnativo per il computer rispetto all'uso di un modello di AI, perché devono essere elaborati milioni di documenti di input. Questo può richiedere settimane, persino mesi sui supercomputer più veloci oggi disponibili per aziende come Microsoft. Nvidia ha precedentemente rilasciato la piattaforma GPU Hopper https://www.nvidia.com/en-us/data-center/technologies/hopper-architecture/ nel 2022 per gestire questi grandi carichi di calcolo.

Al GTC 2024, Huang ha presentato Blackwell come il seguito di Hopper ed è disponibile su una scheda sostitutiva drop-in per le attuali installazioni di Hopper. La GPU Blackwell è composta da due die GPU da 104 miliardi di transistor su un processo TSMC 4NP di https://pr.tsmc.com/english/news/2874 (probabilmente N4P, errore di battitura nella presentazione) per 20 FP4 petaflops con 192GB di memoria HBM3e in grado di trasferire 8TB/s. In confronto, una GPU desktop gPU 4090 ha una singola GPU da 76,3 miliardi di transistor, processo 5NM, fino a 1,32 Tensor FP8 petaflops di prestazioni con 24GB di memoria GDDR6X. Se si raddoppia il numero 4090 FP8 per adattarlo a 4 bit, si tratta di circa 20 petaflop Blackwell contro 3 petaflop 4090.

Quando 72 GPU Blackwell sono posizionate in un singolo armadio DGX GB200 NVL72 con raffreddamento a liquido, CPU NVLink migliorate https://www.nvidia.com/en-us/data-center/nvlink/e altri miglioramenti dell'interconnessione, le prestazioni rispetto ai cabinet Hopper aumentano di 22 volte per l'addestramento AI FP8 e di 45 volte per l'inferenza AI FP4. Anche il consumo energetico dell'addestramento AI di Blackwell è ridotto di circa 4 volte rispetto a Hopper.

Modelli AI preconfezionati NIMS

Per trarre vantaggio da questo salto di prestazioni, Nvidia ha introdotto modelli di AI preconfezionati chiamati NIMS (Nvidia Inference Microservice)utilizzando Kubernetes per essere eseguiti sulle GPU Nvidia CUDA in locale o nel cloud. L'accesso al NIMS stand-alone avviene tramite un'API HUMAN semplificata. L'obiettivo è quello di creare un futuro in cui i servizi di AI vengono creati chiedendo a un'AI di creare un'app con determinate funzionalità, poi l'AI mescola e abbina vari NIMS senza richiedere una programmazione di basso livello. Infine, per assistere la formazione di NIMS, Nvidia ha introdotto NeMO Microservices per personalizzare, valutare e proteggere il processo di formazione sui documenti aziendali.

Nvidia BioNeMO e NIMS biologico

Huang ha annunciato che Nvidia svilupperà NIMS addestrato su dati biologici e medici per fornire ai ricercatori un accesso più facile all'AI che può migliorare tutti gli aspetti della medicina, come ad esempio trovare più velocemente i candidati ai farmaci.

Thor ASIL-D e veicoli EV autonomi BYD

In modo significativo, Huang ha dichiarato che BYD sarà il primo costruttore di auto EV al mondo ad adottare il suo nuovo computer Thor ASIL-D che utilizza un SoC AI per elaborare gli input visivi e di guida, al fine di garantire un'elevata sicurezza nella guida autonoma. Unitamente al recente annuncio di di SuperDrive by Plusquesto fa pensare che BYD sarà una delle prime aziende automobilistiche a rilasciare un veicolo EV autonomo di livello 4 https://www.sae.org/blog/sae-j3016-update di veicolo autonomo EV.

Nvidia Project Groot robot umanoidi

Huang ha dimostrato ulteriormente i suoi progressi nella robotica, mostrando le capacità dei suoi robot, che vengono prima addestrati nell'Omniverso https://www.nvidia.com/en-us/omniverse/ come un gemello digitale, poi vengono autorizzati a completare dei compiti in corpi robotici reali. Sono stati mostrati la cottura, la rotazione delle dita dei bastoncini, lo smistamento e l'assemblaggio dei prodotti e la navigazione intorno agli ostacoli. Per raggiungere questo livello di robotica, il Nvidia Project Groot AI è stata creata addestrandola prima su input testuali, video e dimostrativi, poi è stata ulteriormente perfezionata con osservazioni reali dei compiti svolti. Accoppiato con lo stesso computer Thor utilizzato nei veicoli e Nvidia Tokkio AI modello linguistico, i robot dimostrativi sono stati in grado di osservare le azioni compiute dagli esseri umani, quindi di replicarle per preparare bevande, suonare la batteria e rispondere alle richieste vocali.

Nvidia Omniverse Cloud aggiunge il supporto a Apple Vision Pro

Come nota minore, Huang ha dichiarato che Nvidia Omniverse Cloud ora trasmette in streaming a Apple Vision Pro oltre che alle cuffie Meta Quest e HTC Vive Pro, chiaramente per gli sviluppatori che utilizzano le GPU cloud di Nvidia, dato che nessun Macintosh ha una GPU Nvidia compatibile.

I lettori che desiderano unirsi alla rivoluzione dell'AI vorranno una scheda grafica Nvidia potente(come questa di Amazon) per sviluppare le abilità e le app di AI.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones

NVIDIA lancia il DGX SuperPOD alimentato da Blackwell per il supercomputing generativo di AI su scala di trilioni di parametri

Scala a decine di migliaia di superchip di Grace Blackwell utilizzando le reti NVIDIA più avanzate, il software NVIDIA Full-Stack AI e l'archiviazione. Offre fino a 576 GPU Blackwell collegate come un tutt'uno con NVIDIA NVLink Gli esperti di sistema NVIDIA accelerano l'implementazione di un'infrastruttura AI immediata

18 marzo 2024

gTC-NVIDIA ha annunciato oggi il suo supercomputer di AI di nuova generazione - NVIDIA DGX SuperPOD™ alimentato da Superchip NVIDIA GB200 Grace Blackwell - per l'elaborazione di modelli da trilioni di parametri con un tempo di attività costante per carichi di lavoro di formazione e inferenza di AI generativa su scala supersonica.

Caratterizzato da una nuova architettura su scala rack, altamente efficiente e raffreddata a liquido, il nuovo DGX SuperPOD è costruito con sistemi NVIDIA DGX™ GB200 e offre 11,5 exaflops di supercomputing AI a precisione FP4 e 240 terabyte di memoria veloce - scalando a un numero maggiore con rack aggiuntivi.

Ogni sistema DGX GB200 presenta 36 Superchip NVIDIA GB200 - che includono 36 CPU NVIDIA Grace e 72 GPU NVIDIA Blackwell - collegati come un unico supercomputer tramite NVIDIA NVLink® di quinta generazione. I Superchip GB200 offrono un aumento delle prestazioni fino a 30 volte rispetto alle GPU NVIDIA H100 Tensor Core per i carichi di lavoro di inferenza di modelli linguistici di grandi dimensioni.

"I supercomputer NVIDIA DGX AI sono le fabbriche della rivoluzione industriale dell'AI", ha dichiarato Jensen Huang, fondatore e CEO di NVIDIA. "Il nuovo DGX SuperPOD combina i più recenti progressi nel computing accelerato, nel networking e nel software di NVIDIA per consentire a ogni azienda, industria e paese di perfezionare e generare la propria AI"

Il DGX SuperPOD alimentato da Grace Blackwell comprende otto o più sistemi DGX GB200 e può scalare fino a decine di migliaia di Superchip GB200 collegati tramite NVIDIA Quantum InfiniBand. Per ottenere un enorme spazio di memoria condivisa per alimentare i modelli AI di prossima generazione, i clienti possono implementare una configurazione che collega le 576 GPU Blackwell in otto sistemi DGX GB200 collegati tramite NVLink.

Nuova architettura DGX SuperPOD in scala rack per l'era dell'AI generativa

Il nuovo DGX SuperPOD con i sistemi DGX GB200 presenta un fabric di calcolo unificato. Oltre a NVIDIA NVLink di quinta generazione, il fabric include DPU NVIDIA BlueField®-3 e supporterà la rete InfiniBand NVIDIA Quantum-X800, annunciata separatamente oggi. Questa architettura offre fino a 1.800 gigabyte al secondo di larghezza di banda a ogni GPU della piattaforma.

Inoltre, la tecnologia NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ di quarta generazione offre 14,4 teraflops di In-Network Computing, un aumento di 4 volte nell'architettura DGX SuperPOD di nuova generazione rispetto alla generazione precedente.

L'architettura chiavi in mano si abbina al software avanzato per un tempo di attività senza precedenti

Il nuovo DGX SuperPOD è un supercomputer AI completo, su scala data-center, che si integra con lo storage ad alte prestazioni dei partner certificati da NVIDIA per soddisfare le esigenze dei carichi di lavoro AI generativi. Ognuno di essi viene costruito, cablato e testato in fabbrica per accelerare drasticamente l'implementazione nei data center dei clienti.

Il DGX SuperPOD alimentato da Grace Blackwell è dotato di capacità intelligenti di gestione predittiva per monitorare continuamente migliaia di punti di dati attraverso l'hardware e il software per prevedere e intercettare le fonti di downtime e di inefficienza - risparmiando tempo, energia e costi di elaborazione.

Il software può identificare le aree problematiche e pianificare la manutenzione, regolare in modo flessibile le risorse di calcolo e salvare e riprendere automaticamente i lavori per evitare i tempi di inattività, anche in assenza di amministratori di sistema.

Se il software rileva la necessità di sostituire un componente, il cluster attiverà la capacità di standby per garantire che il lavoro venga completato in tempo. Qualsiasi sostituzione hardware necessaria può essere programmata per evitare tempi di inattività non pianificati.

I sistemi NVIDIA DGX B200 avanzano il supercomputing AI per le industrie

NVIDIA ha anche presentato il sistema NVIDIA DGX B200, una piattaforma di supercomputing AI unificata per l'addestramento, la messa a punto e l'inferenza dei modelli AI.

DGX B200 è la sesta generazione di progetti DGX tradizionali, raffreddati ad aria e montati su rack, utilizzati dalle industrie di tutto il mondo. Il nuovo sistema DGX B200 con architettura Blackwell include otto GPU NVIDIA Blackwell e due processori Intel® Xeon® di quinta generazione. I clienti possono anche costruire DGX SuperPOD usando i sistemi DGX B200 per creare centri di eccellenza AI che possono alimentare il lavoro di grandi team di sviluppatori che eseguono molti lavori diversi.

I sistemi DGX B200 includono la funzione di precisione FP4 della nuova architettura Blackwell, che offre fino a 144 petaflop di prestazioni AI, un enorme 1,4 TB di memoria GPU e 64 TB/s di larghezza di banda della memoria. Questo offre un'inferenza in tempo reale 15 volte più veloce per i modelli da un trilione di parametri rispetto alla generazione precedente.

I sistemi DGX B200 includono un networking avanzato con otto NIC NVIDIA ConnectX™-7 e due DPU BlueField-3. Questi forniscono fino a 400 gigabit al secondo di larghezza di banda per connessione - offrendo prestazioni di IA veloci con le piattaforme di rete NVIDIA Quantum-2 InfiniBand e NVIDIA Spectrum™-X Ethernet.

Software e supporto di esperti per scalare l'AI di produzione

Tutte le piattaforme NVIDIA DGX includono il software NVIDIA AI Enterprise per lo sviluppo e l'implementazione di livello enterprise. I clienti di DGX possono accelerare il loro lavoro con i modelli di fondazione NVIDIA preaddestrati, i framework, i toolkit e i nuovi microservizi NVIDIA NIM inclusi nella piattaforma software.

Gliesperti di NVIDIA DGX e i partner NVIDIA selezionati e certificati per il supporto delle piattaforme DGX assistono i clienti in ogni fase della distribuzione, in modo che possano portare rapidamente l'AI in produzione. Una volta che i sistemi sono operativi, gli esperti di DGX continuano a supportare i clienti nell'ottimizzazione delle loro pipeline e infrastrutture di AI.

Disponibilità

NVIDIA DGX SuperPOD con i sistemi DGX GB200 e DGX B200 dovrebbe essere disponibile entro la fine dell'anno presso i partner globali di NVIDIA.

Per ulteriori informazioni, guardare il replay del keynote del GTC o visitare lo stand NVIDIA al GTC, che si tiene al San Jose Convention Center fino al 21 marzo.