Con la proliferazione dei centri dati AI e dei relativi costi di elaborazione, l'attenzione è ora rivolta all'efficienza dell'algoritmo e nessun modello linguistico sembra farlo meglio di DeepSeek. I suoi modelli sono open source e la loro formazione ha un costo molto più basso rispetto a ChatGPT di OpenAI o a Gemini di Google.

Il modello DeepSeek-OCR, annunciato di recente, è un ottimo esempio di efficienza di apprendimento. Utilizzando la mappatura ottica, può comprimere documenti estremamente lunghi convertendoli in immagini con una precisione di riconoscimento del 97% con un rapporto di compressione inferiore a 10x.

Utilizzando un codificatore e un decodificatore avanzati, più di nove token con il testo del documento possono essere convertiti in un singolo token visivo, riducendo notevolmente le risorse informatiche necessarie per l'elaborazione del contenuto. Anche con un rapporto di compressione 20x, il nuovo sistema DeepSeek-OCR può raggiungere un'accuratezza di riconoscimento ottico del 60%, un'impresa senza precedenti.

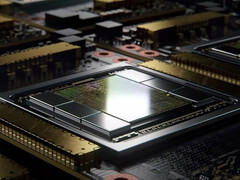

Grazie ai nuovi algoritmi di compressione AI, DeepSeek-OCR può apprendere da testi scientifici o storici elaborati da una singola GPU del data center Nvidia A100 con una velocità di 200.000 pagine al giorno. Un cluster A100 a 20 nodi può quindi elaborare 33 milioni di pagine di documenti al giorno, un cambiamento paradigmatico nell'apprendimento LLM ad alto contenuto di testo. Secondo la classifica di OmniDocBench, DeepSeek-OCR batte di gran lunga altre soluzioni popolari come GOT-OCR2.0 o MinerU2.0 per quanto riguarda il minor numero di token di visione utilizzati per pagina.

I nuovi algoritmi DeepEncoder sono in grado di gestire una gamma di dimensioni e risoluzioni di documenti senza sacrificare la velocità o la precisione, mentre il decodificatore DeepSeek3B-MoE-A570M si affida alla cosiddetta architettura "mixture-of-experts" che distribuisce le conoscenze tra i modelli specializzati necessari per ogni attività OCR. Di conseguenza, DeepSeel-OCR può elaborare documenti complessi con grafici, formule scientifiche, diagrammi o immagini, anche se scritti in diverse lingue.

Per raggiungere una tale scala e precisione, DeepSeek ha esaminato 30 milioni di pagine in formato PDF (Portable Document Format) scritte in quasi 100 lingue, che comprendevano ogni singola categoria in circolazione, dai giornali e dalla calligrafia scientifica ai libri di testo e alle tesi di dottorato. Tuttavia, mentre la velocità e l'efficienza della tokenizzazione visiva raggiunta con il nuovo sistema DeepSeek-OCR sono innegabili, resta da vedere se questo porterà a un miglioramento delle prestazioni del modello linguistico quando si tratta di ragionare effettivamente, rispetto all'attuale paradigma di token basato sul testo.

Fonte(i)

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones