OpenAI ha annunciato il rilascio di gpt-oss-120b e gpt-oss-20b, due modelli open-source che possono essere scaricati gratuitamente ed eseguiti localmente sul proprio sistema. Si tratta del primo rilascio open-source dell'azienda dopo il lancio di GPT-2 nel 2019.

Gpt-oss-120b è il modello da 117 miliardi di parametri che richiede ben 80 GB di VRAM per essere eseguito. Il modello più piccolo gpt-oss-20b, da 21 miliardi di parametri, può essere inserito in una singola GPU con 16 GB di VRAM. Entrambi i modelli sono disponibili con una licenza Apache 2.0 flessibile.

OpenAI afferma che "il rilascio è un passo significativo nel suo impegno verso l'ecosistema open-source, in linea con la sua missione dichiarata di rendere i vantaggi dell'AI ampiamente accessibili" L'azienda vuole che servano come strumento a basso costo per gli sviluppatori, i ricercatori e le aziende, in modo da poterli gestire e personalizzare in modo efficiente.

Come si comportano?

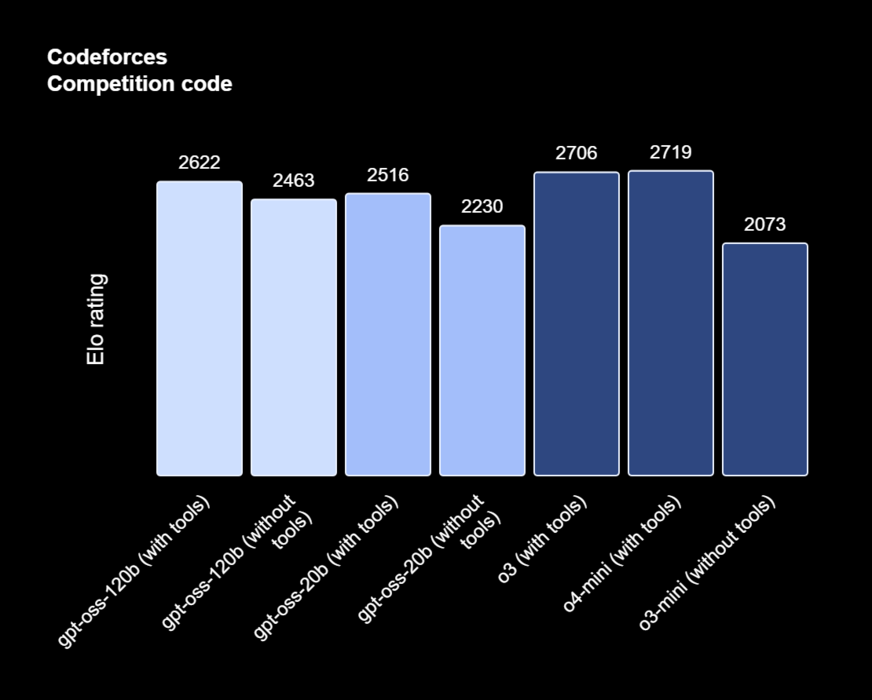

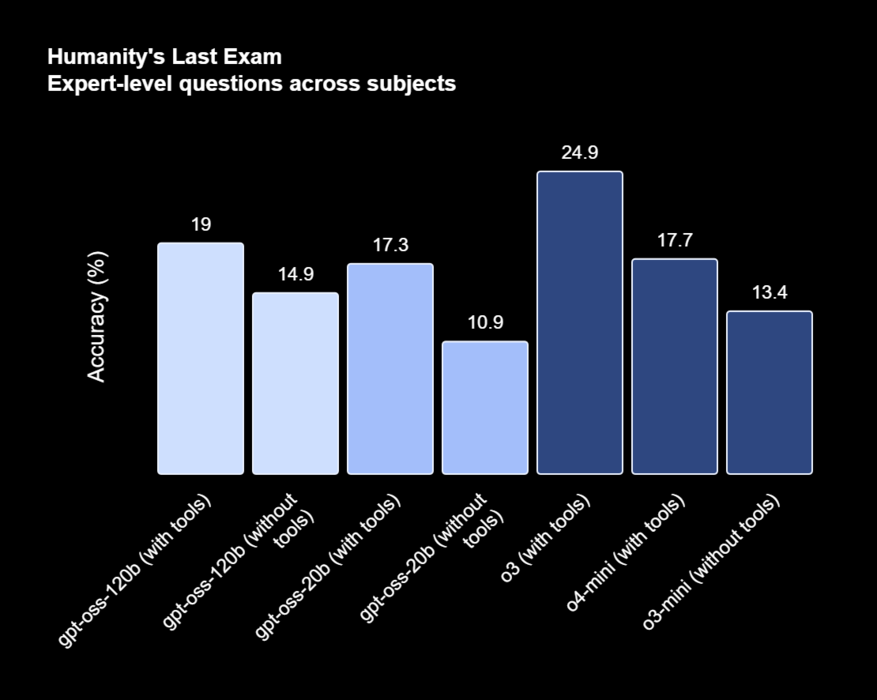

Il gpt-oss-120b ha ottenuto 2622 punti nel test di codifica di Codeforces con gli strumenti, con prestazioni quasi uguali a quelle di o3 e o4-mini dell'azienda, e battendo comodamente o3-mini in entrambi i test, con un punteggio di 2643 senza strumenti.

Il gpt-oss-20b ha ottenuto un punteggio di 2516 con gli strumenti, con prestazioni alla pari con o3 e o4-mini con o3 e o4-mini, e 2230 senza strumenti, superando di poco o3-mini. OpenAI afferma che 120b fa ancora meglio nelle domande relative alla salute e alla matematica rispetto a o4-mini, mentre 20b supera o3-mini.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones

OpenAI afferma che sia il 120b che il 20b tendono ad avere molte più allucinazioni rispetto ai modelli di ragionamento come o3 e o4-mini. Nei test, hanno riscontrato che entrambi i modelli di peso aperto hanno avuto allucinazioni tra il 49% e il 53% nei loro benchmark interni che testano i modelli sulla conoscenza delle persone.

Entrambi i modelli possono essere scaricati dallo spazio ufficiale Hugging Face e sono quantizzati nativamente in MXFP4 per una maggiore efficienza. Possono anche essere distribuiti liberamente su piattaforme come Microsoft Azure, Hugging Face, vLLM, Ollama e llama.cpp, LM Studio, AWS, Fireworks, Together AI e molto altro ancora.

OpenAI si aspetta che questi modelli "riducano le barriere per i mercati emergenti, i settori con risorse limitate e le organizzazioni più piccole che potrebbero non avere il budget o la flessibilità per adottare modelli proprietari"

Per quanto riguarda il motivo dell'open-sourcing di un nuovo modello, sei anni dopo l'ultimo, l'azienda afferma di voler "rendere l'AI ampiamente accessibile e vantaggiosa per tutti"