Samsung spedisce la memoria AI più costosa mai ordinata da Nvidia, poiché l'HBM4 supera le specifiche chiave

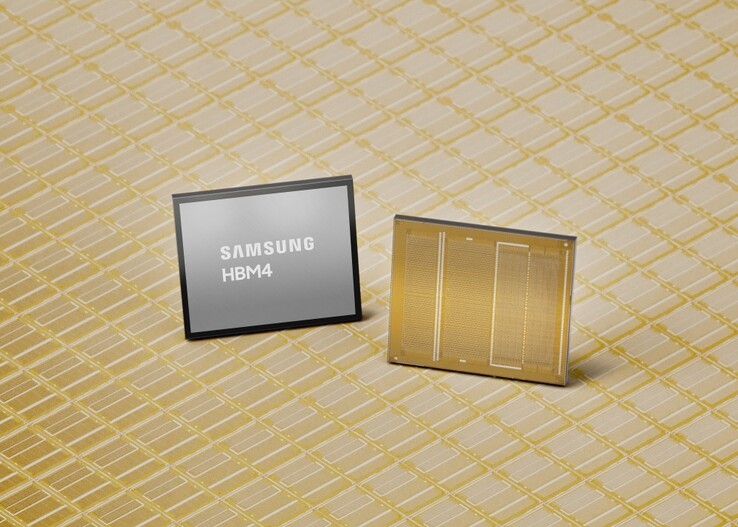

Samsung ha annunciato le prime spedizioni commerciali di una memoria HBM4 di nuova generazione per applicazioni come le GPU Nvidia e i rispettivi data center AI.

Secondo quanto riferito, Nvidia e altri clienti stanno pagano quasi 500 dollari a pezzo a Samsung, il doppio di quanto pagavano per la precedente generazione di memoria ad alta larghezza di banda HBM3E. Di conseguenza, le azioni di Samsung sono ai massimi storici e la sua dirigenza si aspetta un altro anno da blockbuster, sfruttando la carenza di memoria generale carenza di memoria.

Specifiche della memoria HBM4 di Samsung

Mentre i produttori di memoria attualmente fanno pagare un occhio della testa per ogni unità prodotta, Samsung afferma che la sua nuova memoria HBM4 AI è riuscita a superare sia lo standard Joint Electron Device Engineering Council (JEDEC) che i requisiti di Nvidia.

La velocità operativa HBM4 può raggiungere ben 13 Gbps, ovvero il 46% in più rispetto ai requisiti JEDEC, e la larghezza di banda totale della memoria raggiunge i 3,3 TB/s per stack, superando di gran lunga i 3 TB/s richiesti da clienti come Nvidia.

Samsung ha ottenuto questo throughput a rotta di collo applicando preventivamente il processo DRAM 1c di 6a generazione a 10 nm con il die di base prodotto a 4 nm, rispetto al DRAM 1a a 14 nm utilizzato per il predecessore HBM3. Ciò offre alla generazione di memoria HBM4 AI un ampio margine di miglioramento del processo e delle prestazioni. Per gestire tutto il calore generato, Samsung ha progettato il core die e la trasmissione dei dati con tecnologie a basso consumo e a bassa tensione per una dissipazione del calore migliore del 30% e un'efficienza energetica superiore del 40% rispetto alla generazione di memoria HBM3 che Nvidia sta utilizzando nelle sue schede grafiche AI della serie Blackwell.

Per il momento, Samsung è in grado di fornire ai clienti un massimo di 36 GB di capacità di memoria HBM4 tramite uno stack a 12 strati, ma può anche realizzare uno stacking a 16 strati per un totale di 48 GB, quando Nvidia sarà pronta con il rispettivo design e potere d'acquisto della GPU. Samsung promette un numero sufficiente di costosi chip HBM4, affermando che"continuerà a garantire capacità di fornitura stabili per soddisfare la crescente domanda a medio e lungo termine, in particolare da parte dell'AI e dei data center", mentre inizierà a campionare la sua memoria HBM4E di nuova generazione nella seconda metà del 2026.

Acquisti il kit di memoria Crucial DDR5 da 64 GB per computer portatili su Amazon

Fonte(i)

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones