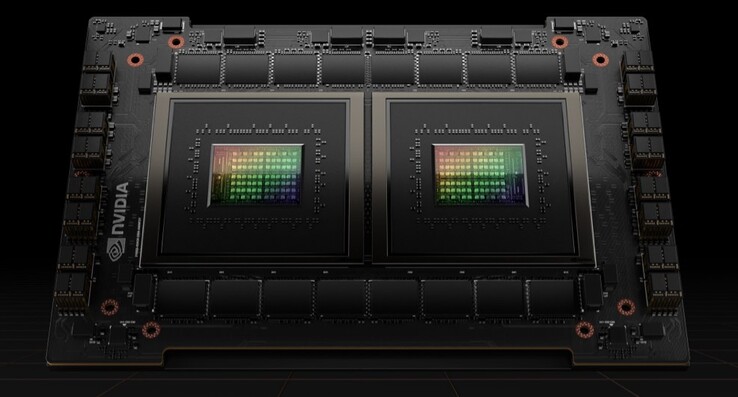

Le GPU Hopper H100 AI e HPC di Nvidia sono state appena presentate al GTC insieme ai superchip Grace. Come sempre, i modelli di GPU di calcolo sono altamente scalabili, e Nvidia offre varie soluzioni multi-GPU per soddisfare le diverse esigenze dei data center. Una singola GPU H100 Tensor Core, d'altra parte, è dotata di miglioramenti significativi rispetto alla 2020 Ampere A100 soprattutto nel reparto operazioni FP.

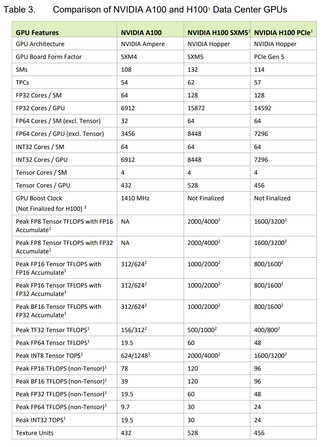

Prima di tutto la GPU H100 è fabbricata su Nodi a 4 nm di TSMC e ha un die di 814 mm² (14 mm² più piccolo dell'A100). Questo modello è il primo di Nvidia a disporre di PCIe 5.0 e c'è anche un fattore di forma SXM che è più veloce. La GPU stessa comprende non meno di 80 miliardi di transistor, il che rappresenta un aumento di quasi il 50% rispetto alla A100. Dispone anche di 132 cluster GPU con 16896 core CUDA per lo standard SXM e 14592 core CUDA per lo standard PCIe 5.0, più che raddoppiando il conteggio dalla generazione precedente

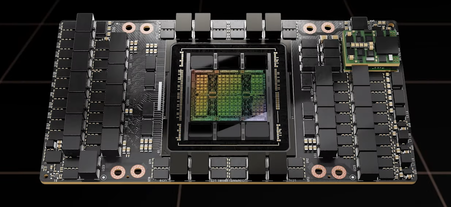

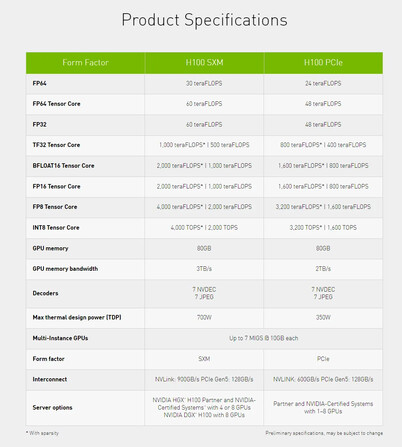

La cache L2 è aumentata da 40 MB a 50 MB, ma il bus di memoria rimane lo stesso a 5120 bit, e la capacità di memoria è impostata su 80 GB HBM3 con 3 o 2 TB/s di larghezza di banda a seconda del fattore di forma. La versione SXM ha 528 core Tensor e richiede 700 W, mentre la versione PCIe ha solo 456 core Tensor ed è limitata a 350 W TGP-wise. Nvidia sostiene che 20x GPU H100 possono sostenere l'equivalente dell'intero traffico Internet mondiale, ma la nuova architettura può essere scalata fino a centinaia e persino migliaia di cluster DGX che saranno utilizzati nei futuri supercomputer

Per quanto riguarda le prestazioni FP, la GPU H100 può elaborare 4 PFLOPS di FP8 (6x su A100), 2 PFLOPS di FP16 (3x su A100), 1 PFLOPS di TF32 (3x su A100) e 60 TFLOPS di FP64/FP32 (3x su A100). Miglioramenti simili possono essere ottenuti con i calcoli Tensor Core FP.

Nvidia sta anche progettando di rilasciare una Grace Hopper superchip che combina una GPU H100 e una CPU Grace collegate insieme con un NVLink da 900 GB/s. Allo stesso modo, ci sarà anche un superchip Grace che combina due CPU Grace che offrono 144 core ARM, 1 TB/s LPDDR5x e 396 MB di cache on-chip. Questo superchip Grace può essere accoppiato con un massimo di otto GPU Hopper, ma tali configurazioni non saranno disponibili prima del Q3 2023. Le GPU Hopper di Nvidia, invece, inizieranno a essere distribuite nel terzo trimestre del 2022.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones