Microsoft ha lanciato Phi-3 all'inizio di questa settimana su HuggingFace, Ollama e il catalogo Azure AI. Anche se non è all'altezza delle capacità di conoscenza generale di Windows Copilotla tecnologia AI open-source rappresenta la quarta generazione di piccoli modelli linguistici di Redmond che rivaleggiano con gli LLM tradizionali in termini di velocità, efficienza e prestazioni.

Con 3,8 miliardi di parametri, Phi-3 è leggermente più grande di il suo predecessore ma rimane abbastanza piccolo da poter essere eseguito su appena 1,8 GB di memoria mobile. A titolo di confronto, un tipico LLM complesso come Llama o GPT-3.5 utilizza centinaia di miliardi di parametri per comprendere l'input e non è pratico da memorizzare in modo nativo. GPT-5, che verrà lanciato quest'estatesi prevede che le dimensioni saranno di trilioni di parametri. Secondo le leggi di scala convenzionali, più parametri significano risultati più intelligenti. Ma secondo Microsoft, questo potrebbe non essere necessariamente il caso.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones

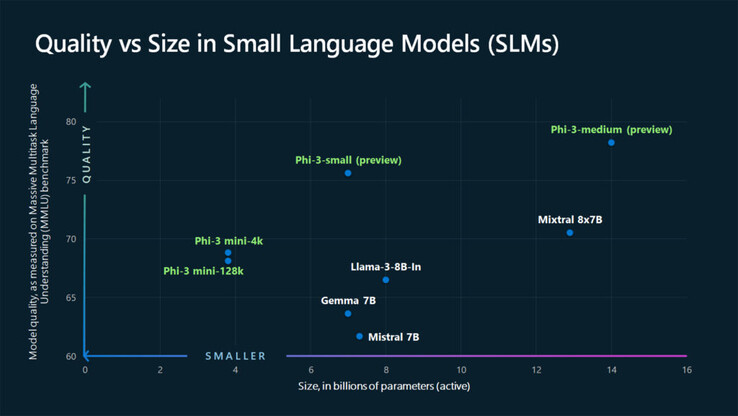

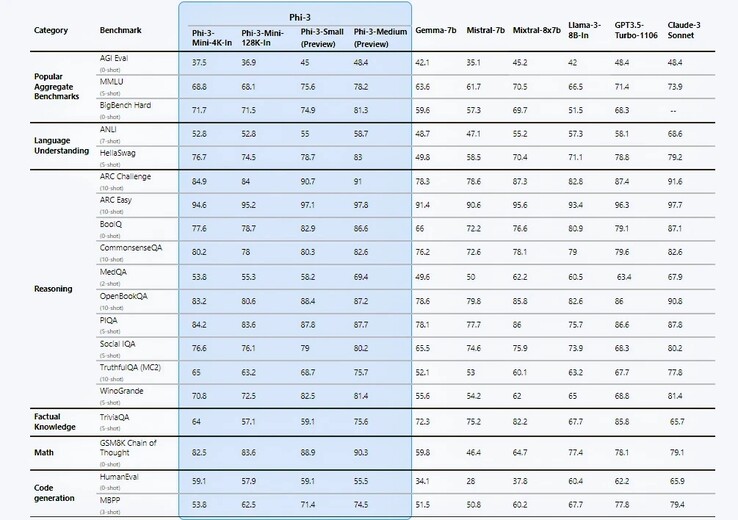

Microsoft fa alcune affermazioni audaci nella sua relazione tecnica https://arxiv.org/pdf/2404.14219; il principale di questi è rappresentato dai benchmark delle prestazioni che, per stessa ammissione dell'azienda, sono puramente accademici. In 12 dei 19 test di benchmark, Phi-3-mini sembra superare Llama-3-instruct, pur funzionando con più del doppio dei parametri. Con Phi-3-small da 7B e Phi-3-medium da 14B, i risultati sono stati ancora più sbalorditivi.

Gli ingegneri attribuiscono questi guadagni di efficienza al loro set di dati di addestramento accuratamente curati derivato da due fonti: contenuti web di 'qualità testuale' e dati generati dall'AI, progettati per insegnare il linguaggio, la conoscenza generale e il ragionamento di buon senso, con un elenco selezionato di 3000 parole che fungono da elementi di base. I ricercatori di Microsoft sostengono che questo tipo di ricetta di dati ha permesso al Phi-2 dello scorso anno di eguagliare le prestazioni del modello Meta, notevolmente più grande (70 B) Modello Llama-2.

Eric Boyd, VP aziendale di Azure AI, si vanta attraverso The Verge che Phi-3 è altrettanto capace di GPT-3.5, anche se in un "fattore di forma più piccolo". Tuttavia, Phi-3 continua ad essere afflitto da una carenza di conoscenza dei fatti a causa delle sue dimensioni limitate. Forse si tratta di un compromesso necessario per far funzionare l'AI in modo nativo invece che tramite il cloud computing?

Considerando che la flessibilità e l'efficienza dei costi sono temi chiave per le aziende, non sorprende che le imprese abbiano già iniziato a sfruttare le capacità degli SLM. Tuttavia, Phi-3 ha una forte concorrenza. Llama-3 di Meta, la suite Claude-3 di Anthropic, Google Gemini e Gemma hanno tutti versioni leggere che sono in grado di supportare l'edge computing su mobile. E sebbene Phi-3 sembri competere favorevolmente, Gemini Nano è già arrivato su dispositivi come Google Pixel 8 Pro e Samsung Galaxy serie S24(784 dollari su Amazon).

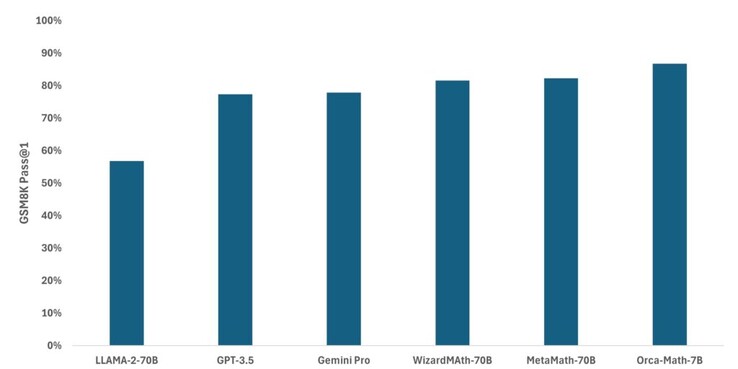

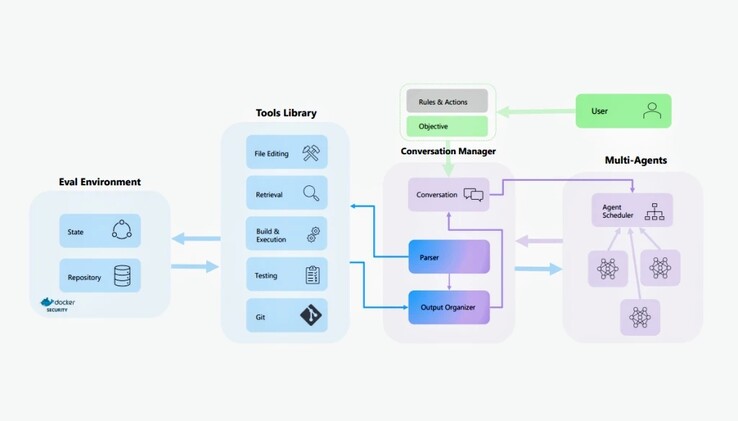

La famiglia Phi-3 di modelli AI non è affatto l'unico SLM su cui Microsoft sta lavorando. Il mese scorso, l'azienda ha adattato Mistral per creare Orca-Mathun modello specializzato che ha dimostrato di essere notevolmente più preciso di Llama, GPT-3.5 e Gemini Pro nella matematica delle elementari. AutoDev, un progetto più recente, si basa su AutoGen e Auto-GPT per pianificare ed eseguire autonomamente compiti di programmazione basati su obiettivi definiti dall'utente. Le guerre dell'intelligenza artificiale sono tutt'altro che finite, ma almeno sulla scala più bassa, abbiamo un concorrente di primo piano.

![Microsoft vuole sapere se prenderebbe in considerazione l'acquisto di un nuovo palmare da gioco nei prossimi cinque anni (Fonte immagine: Logitech [modificato])](fileadmin/_processed_/a/0/csm_Logitech-G-Cloud_f62f43f9e7.jpg)

![GameSir X4 viene lanciato in Cina come controller di gioco mobile autorizzato da Microsoft (Fonte immagine: JD.com [Edited])](fileadmin/_processed_/c/e/csm_GameSir-X4_3e573ba58e.jpg)