Mentre Nvidia sta attualmente godendo di profitti eccezionali cavalcando l'onda dell'AI con la crescente domanda di GPU di calcolo, il mercato potrebbe diventare più decentralizzato quando altre aziende si faranno avanti per fornire processori AI alternativi e validi. Abbiamo visto gli sforzi di diverse aziende in questo senso, tra cui AMD, d-Matrix, OpenAI e Samsung. Sembra che alcuni ingegneri che hanno contribuito alla progettazione dell'unità di elaborazione tensoriale (TPU) di Google siano ora coinvolti in progetti AI indipendenti che promettono di surclassare le soluzioni di Nvidia. Samsung, ad esempio, ha recentemente annunciato che il suo nuovo AGI Computing Lab aperto nella Silicon Valley è guidato dall'ex sviluppatore della TPU di Google, il Dr. Woo Dong-hyuk. Un altro ingegnere chiave che ha contribuito allo sviluppo della TPU di Google è Jonathan Ross, che ora è il CEO di una nuova azienda chiamata Groq. Sfruttando l'esperienza accumulata in Google, Ross porta l'innovazione nel mercato degli acceleratori AI con la prima Language Processing Unit (LPU) al mondo.

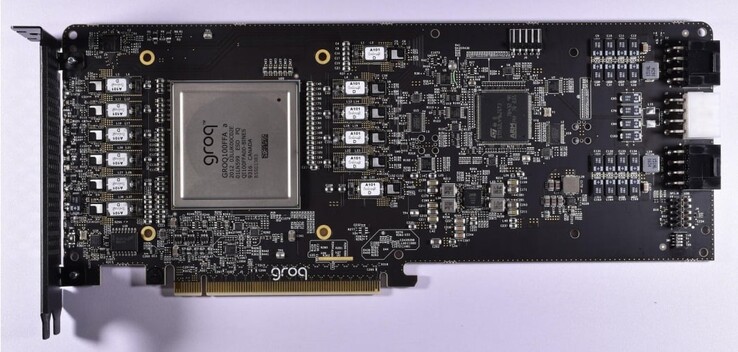

La LPU di Groq è progettata specificamente per elaborare modelli linguistici di grandi dimensioni (LLM) e presenta chiari vantaggi rispetto alle GPU generiche o alle NPUs. Groq ha inizialmente sviluppato il Tensor Stream Processor (TSP), che in seguito è stato ribattezzato unità di elaborazione linguistica per riflettere la sua maggiore competenza nei compiti di IA generativa basati sull'inferenza. Essendo focalizzata esclusivamente sugli LLM, la LPU è molto più snella di una GPGPU e consente una programmazione hardware semplificata con una latenza inferiore, un throughput sostenuto e una maggiore efficienza.

Di conseguenza, l'LPU riduce il tempo di calcolo per parola e le sequenze di testo possono essere generate molto più velocemente. Un altro miglioramento chiave è che la LPU elimina la necessità di una memoria costosa (HBM), in quanto utilizza solo 230 MB di SRAM per chip con una larghezza di banda di 80 TB/s, rendendola notevolmente più veloce rispetto alle soluzioni GPGPU tradizionali. L'architettura di Groq supporta anche la scalabilità, in quanto più LPU possono essere interconnessi per fornire una maggiore potenza di elaborazione per gli LLM più complessi.

Per dimostrare quanto sia più veloce il motore di inferenza LPU rispetto alle GPU, Groq fornisce un video di confronto del proprio chatbot che può passare dagli LLM Llama 2 / Mixtral a quello di OpenAI Chat-GPT. Groq sostiene che l'LLM genera il testo in una frazione di secondo, mentre gli altri 3 ⁄ 4 del tempo vengono impiegati per cercare le informazioni pertinenti.

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones