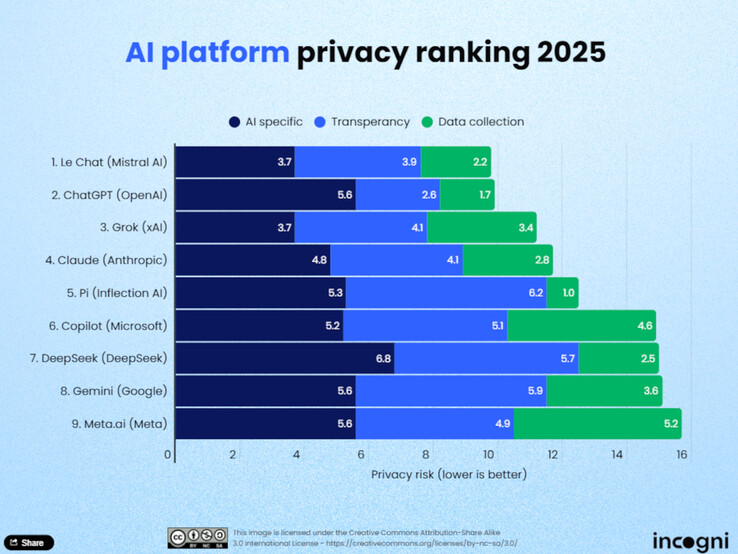

L'uso dell'intelligenza artificiale (AI) nella vita di tutti i giorni sta aumentando, e con esso l'importanza della protezione dei dati. Gli analisti della protezione dei dati di Incogni hanno recentemente valutato nove modelli linguistici di grandi dimensioni (LLM) per determinare quali piattaforme rispettano maggiormente la privacy degli utenti. Lo studio valuta i modelli AI in base a undici criteri suddivisi in tre categorie principali: raccolta di dati per l'addestramento, trasparenza e utilizzo e condivisione dei dati.

Classifiche top

Le Chat di Mistral AI guida la classifica. Secondo Incogni, il modello raccoglie relativamente pochi dati degli utenti e offre un approccio molto efficiente dal punto di vista dei dati, sia durante la fase di addestramento che durante il funzionamento dal vivo. Segue a ruota ChatGPT di OpenAI, che ottiene punti soprattutto per la sua trasparenza. Gli utenti possono specificare nel loro account se le loro chat possono essere utilizzate per sviluppare ulteriormente il modello, e se la cronologia viene disattivata, l'archiviazione viene impedita. Grok di xAI si aggiudica il terzo posto, impressionando anche per le sue pratiche trasparenti di protezione dei dati.

Ultimo in classifica

In fondo alla classifica ci sono Meta AI, Gemini di Google e Copilot di Microsoft. Secondo Incogni, queste piattaforme raccolgono molti dati senza offrire agli utenti chiare opzioni di opt-out. Anche DeepSeek, un modello cinese, si comporta male. Questi fornitori non offrono opzioni chiare per escludere i dati degli utenti dalla formazione.

Metodologia

Gli analisti di Incogni hanno valutato le piattaforme in base a undici criteri suddivisi in tre categorie: raccolta di dati per la formazione, trasparenza e uso e condivisione dei dati. La categoria "uso e condivisione dei dati" ha rappresentato il 50% della valutazione complessiva, mentre la "trasparenza" ha rappresentato il 30% e i "dati di formazione" il 20%. Solo quattro dei nove strumenti testati consentono agli utenti di escludere attivamente i propri dati dalla formazione.

Conclusione

Lo studio dimostra che la protezione dei dati non è ancora uno standard ovunque nel mondo dell'AI. Gli utenti dovrebbero quindi familiarizzare attivamente con le politiche sulla privacy dei fornitori, soprattutto quando si tratta di contenuti sensibili, informazioni riservate sui clienti o dati personali. Coloro che tengono alla protezione dei dati troveranno opzioni ragionevoli in Le Chat, ChatGPT o Grok. Tuttavia, i LLM veramente efficienti dal punto di vista dei dati saranno ancora un'eccezione nel 2025

Fonte(i)

I nostri Top 10

» Top 10 Portatili Multimedia

» Top 10 Portatili Gaming

» Top 10 Portatili Gaming Leggeri

» Top 10 Portatili da Ufficio e Business economici

» Top 10 Portatili Premium da Ufficio/Business

» Top 10 Portatili sotto i 300 Euro

» Top 10 Portatili sotto i 500 Euro

» Top 10 dei Portatili Workstation

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Convertibili

» Top 10 Tablets

» Top 10 Tablets Windows

» Top 10 Smartphones